DataCrunch Blog

- All

- Customer stories

- News

- GPU comparison

- Monthly digests

- Guides

- Benchmarks

- Technical analyses

- Legacy

NEW Benchmarks

DeepSeek V3 NVIDIA H200 Inferenz-Benchmarking

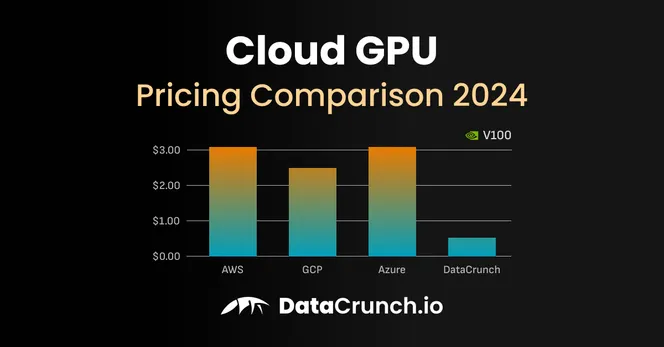

NEW GPU comparison

Vergleich der Preise für Cloud-GPUs im Jahr 2025

DataCrunch führt Europa bei der Bereitstellung der neuen NVIDIA H200 GPUs an

News

DataCrunch.io sichert sich 13 Millionen US-Dollar in Seed-Finanzierungsrunde zur Transformation des KI-Computings

News

NVIDIA H200 vs H100: Hauptunterschiede für KI-Workloads

Legacy

NVIDIA GB200 NVL72 für KI-Training und -Inference

Legacy

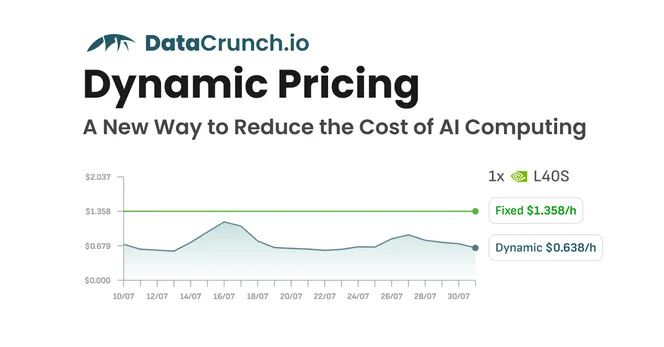

Einführung der dynamischen Preisgestaltung für Cloud-GPU-Instanzen – Ein neuer Weg, die Kosten für KI-Computing zu senken

News

Vergleich von PCIe und SXM5 für NVIDIA H100 Tensor-Core Grafikprozessor

Legacy

NVIDIA H200 – Wie 141GB HBM3e und 4,8TB Speicherbandbreite die ML-Leistung beeinflussen

Legacy

NVIDIA Blackwell B100, B200 GPU-Spezifikationen und Verfügbarkeit

Legacy

NVIDIA A100 GPU-Spezifikationen, Preis und Alternativen im Jahr 2024

Legacy

NVIDIA A100 PCIe vs. SXM4 Vergleich und Anwendungsfälle im Jahr 2024

Legacy

NVIDIA A100 40GB vs 80GB GPU Vergleich (2024)

Legacy

A100 vs V100 – Vergleich der Spezifikationen, Leistung und Preise im Jahr 2024

Legacy

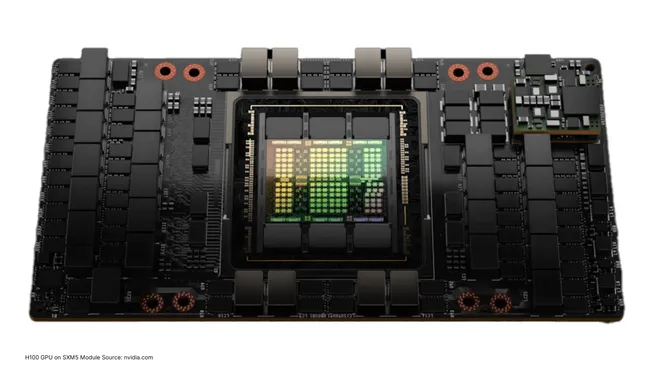

NVIDIA H100 GPU-Spezifikationen und Preis für ML-Training und Inferenz

Legacy

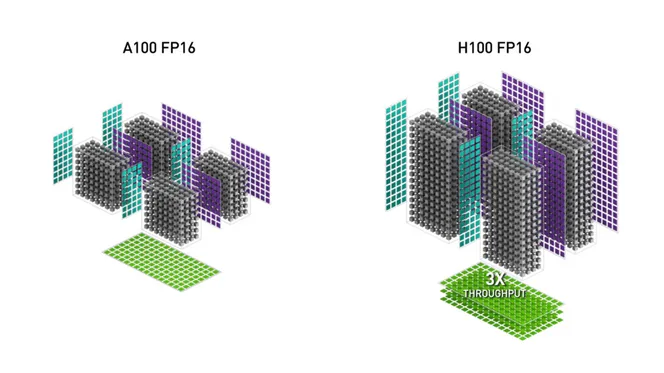

NVIDIA H100 vs A100 GPUs – Preis- und Leistungsvergleich für KI-Training und -Inference

Legacy