Die RTX 6000 ADA ist eine unberechenbare Wahl für jedes KI-Trainings- und Inferenzprojekt. Obwohl sie nicht über die Multi-GPU-Konnektivität von GPUs mit Rechenzentrumsfokus verfügt, bietet die ADA eine Reihe von Funktionen, die sie zu einer soliden Wahl für viele KI-Initiativen machen.

Lassen Sie uns die wichtigsten Fähigkeiten der RTX 6000 ADA überprüfen und ihre Anwendungsfälle mit anderen Hochleistungs-GPUs auf dem Markt wie der A6000, A100 und H100 vergleichen. Dieser Vergleich hilft Ihnen zu verstehen, wo die RTX 6000 ADA in NVIDIAs aktueller GPU-Produktpalette steht und wie sie Ihrem nächsten KI-Projekt zugutekommen könnte.

Überblick über die NVIDIA RTX 6000 ADA GPU

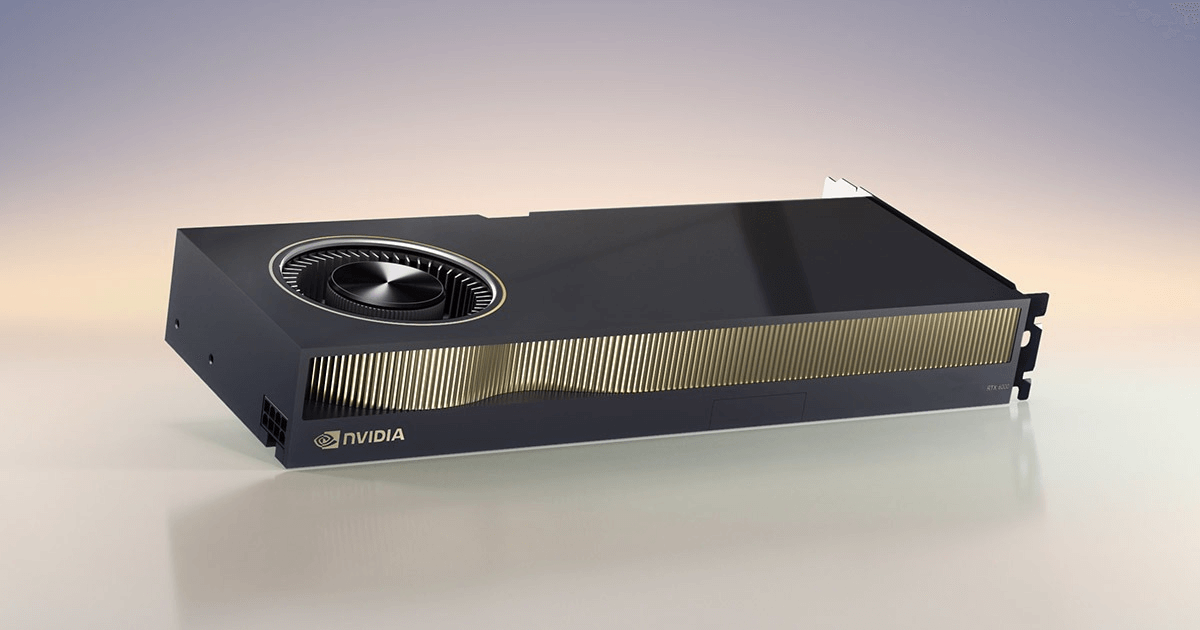

Die RTX 6000 ADA ist eine leistungsstarke Workstation-Grafikkarte, die von NVIDIA im Jahr 2022 veröffentlicht wurde. Während sie einige Designkomponenten mit NVIDIA-Gaming-Grafikkarten wie der NVIDIA RTX 4090 teilt, ist sie speziell für Hochleistungs-Workstation-Computing in einer professionellen Umgebung konzipiert.

Die NVIDIA RTX 6000 ADA basiert auf der Ada Lovelace-Architektur. Sie verfügt über 18.176 CUDA Cores und 568 Tensor Cores der vierten Generation, die eine starke Leistung für KI-Aufgaben bieten. Darüber hinaus umfasst sie 142 RT-Kerne der dritten Generation, die besonders nützlich für Workloads wie Echtzeit-Rendering und komplexe Simulationen sind.

Mit einer Einfachpräzisionsleistung von 91,1 TFLOPS gehört die RTX 6000 ADA zu den leistungsstärksten Workstation-GPUs im Bereich der KI-Leistung. Sie ist mit 48 GB GDDR6 ECC-Speicher ausgestattet und bietet eine beachtliche Speicherbandbreite von 960 GB/s. Die GPU hat einen relativ niedrigen Stromverbrauch von 300W und nutzt PCIe Gen 4.

Diese GPU ist in erster Linie für KI-Forscher, Datenwissenschaftler und Fachleute konzipiert, die leistungsstarke Workstation-Fähigkeiten benötigen. In dieser Rolle wird sie am häufigsten mit der A6000 verglichen. Es ist auch nützlich, sie gegen wichtige Spezifikationen der A100 und H100 zu messen.

Vergleichstabelle der wichtigsten Spezifikationen: A6000, RTX 6000 ADA, A100 & H100

Spezifikation | NVIDIA A6000 | NVIDIA A100 | NVIDIA RTX 6000 ADA | NVIDIA H100 |

|---|---|---|---|---|

Architektur | Ampere | Ampere | Ada Lovelace | Hopper |

CUDA-Kerne | 10.752 | 6.912 | 18.176 | 14.592 |

Tensor-Kerne | 336 (3. Gen) | 432 (3. Gen) | 568 (4. Gen) | 456 (4. Gen) |

Einfachpräzisionsleistung | 38,7 TFLOPS | 19,5 TFLOPS | 91,1 TFLOPS | 67 TFLOPS |

Tensor (FP16) Leistung | 309 TFLOPS | Bis zu 624 TFLOPS | Bis zu 1457 FLOPS | Bis zu 1978 FLOPS |

Speicher | 48 GB GDDR6 ECC | 40 GB oder 80 GB HBM2e | 48 GB GDDR6 ECC | 80 GB HBM3 |

Speicherbandbreite | 768 GB/s | 1.555 GB/s | 960 GB/s | 3.000 GB/s |

Stromverbrauch | 300W | Bis zu 400W | 300W | Bis zu 700W |

Interconnect | PCIe Gen 4 | PCIe Gen 4 (PCIe-Variante), NVLink | PCIe Gen 4 | PCIe Gen 5 (PCIe-Variante), NVLink |

NVLink-Unterstützung | Für 2x A6000s | Ja | Nein | Ja |

Zielumgebung | Workstation | Rechenzentrum | Workstation | Rechenzentrum |

Multi-GPU-Skalierbarkeit | Moderat | Hoch | Eingeschränkt | Hoch |

Veröffentlichungsjahr | 2020 | 2020 | 2022 | 2022 |

Für zusätzliche GPU-Vergleiche siehe A100 vs H100 und L40S vs A100 und H100.

Vergleich der RTX 6000 ADA mit der NVIDIA A6000

Die RTX 6000 ADA basiert auf der Ada Lovelace-Architektur, während die A6000 die Ampere-Architektur nutzt. Dieses Upgrade in der Architektur verschafft der RTX 6000 ADA mehrere Vorteile in Bezug auf Leistung und Effizienz.

Leistungskennzahlen

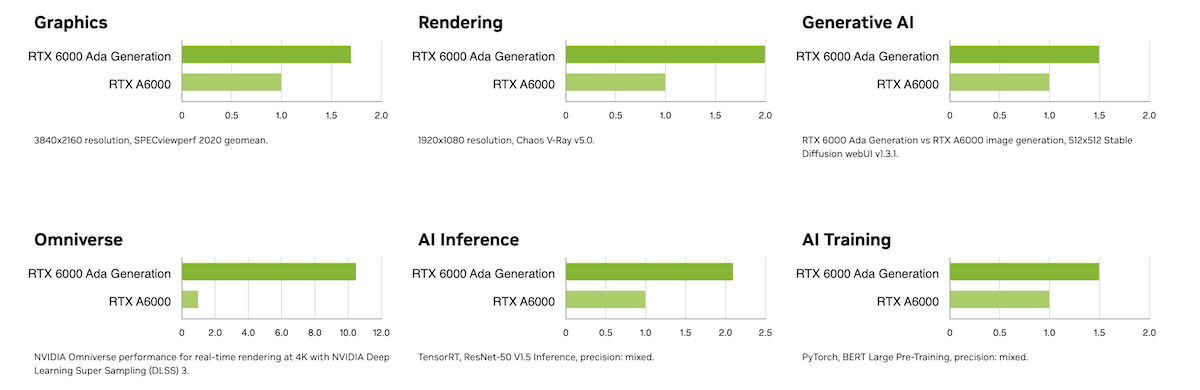

Die RTX 6000 ADA verfügt über 18.176 CUDA-Kerne im Vergleich zu den 10.752 CUDA-Kernen der A6000. Dieser Unterschied führt zu einer erheblichen Steigerung der Rechenleistung. Die RTX 6000 ADA liefert 91,1 TFLOPS an Einfachpräzisionsleistung, während die A6000 38,7 TFLOPS bietet.

Im Bereich der Tensor-Leistung bietet die RTX 6000 ADA bis zu 1,45 PFLOPS, während die A6000 bis zu 1,25 PFLOPS erreicht. Dies macht die RTX 6000 ADA besser geeignet für KI-Trainings- und Inferenzaufgaben, die umfangreiche Tensor-Berechnungen erfordern.

Speicher und Bandbreite

Beide GPUs verfügen über 48 GB GDDR6 ECC-Speicher. Die RTX 6000 ADA bietet jedoch eine höhere Speicherbandbreite von 960 GB/s im Vergleich zu den 768 GB/s der A6000. Diese erhöhte Bandbreite ermöglicht schnellere Datenübertragungen und eine verbesserte Leistung bei speicherintensiven Anwendungen.

Energieeffizienz

Beide GPUs verbrauchen 300W. Allerdings ermöglicht die Architektur der RTX 6000 ADA eine weitaus bessere Leistung pro Watt, was sie effizienter in Bezug auf die Rechenleistung im Verhältnis zum Energieverbrauch macht.

Zusammenfassung RTX 6000 ADA vs A6000

Die RTX 6000 ADA ist ideal für hochentwickelte KI-Trainings, komplexe Simulationen und Echtzeit-Rendering. Ihre fortschrittlichen Funktionen machen sie für Fachleute geeignet, die erstklassige Leistung in einer Workstation-Umgebung benötigen. Die A6000 hingegen ist ausreichend für Aufgaben wie 3D-Rendering, Videobearbeitung und mittlere KI-Trainings.

Vergleich der RTX 6000 ADA mit der NVIDIA A100

Ein weiterer häufiger Vergleichspunkt ist zwischen der RTX 6000 ADA und der NVIDIA A100. Die RTX 6000 ADA ist eine Workstation-GPU, während die A100 hauptsächlich für Rechenzentren entwickelt wurde. Dieser grundlegende Unterschied beeinflusst ihre Architektur und Fähigkeiten.

Leistungskennzahlen

Die RTX 6000 ADA hat 18.176 CUDA-Kerne, deutlich mehr als die 6.912 CUDA-Kerne der A100. Dies gibt der RTX 6000 ADA einen Vorteil in Bezug auf die rohe Rechenleistung. Ihre Einfachpräzisionsleistung beträgt 91,1 TFLOPS im Vergleich zu 19,5 TFLOPS der A100. Allerdings ist die A100 für Mixed-Precision- und Tensor-Operationen optimiert und bietet bis zu 624 TFLOPS an Tensor-Leistung.

Der Leistungsvorteil der RTX 6000 resultiert aus der leistungsstarken Ada Lovelace GPU-Architektur.

Speicher und Bandbreite

Die RTX 6000 ADA verfügt über 48 GB GDDR6 ECC-Speicher mit einer Bandbreite von 960 GB/s. Die A100 bietet zwei Varianten: 40 GB oder 80 GB HBM2e-Speicher mit einer deutlich höheren Bandbreite von 1.555 GB/s. Diese höhere Speicherbandbreite unterstützt größere Modelle und Datensätze, die für fortschrittliche KI- und ML-Aufgaben entscheidend sind.

NVLink und Skalierbarkeit

Ein wesentlicher Unterschied ist das Fehlen von NVLink-Unterstützung in der RTX 6000 ADA. Die A100 unterstützt NVLink und bietet bis zu 600 GB/s GPU-zu-GPU-Interconnect-Bandbreite. Dies macht die A100 hoch skalierbar und geeignet für groß angelegte KI-Trainings-Setups, die mehrere GPUs erfordern.

Zusammenfassung RTX 6000 ADA vs A100

Die RTX 6000 ADA ist ideal für Hochleistungsrechenaufgaben in Workstations, einschließlich KI-Training und -Inference, Echtzeit-Rendering und komplexen Simulationen. Die A100 ist optimal für groß angelegte KI-Trainings und -Inferenzen in Rechenzentren. Ihre Skalierbarkeit und Speicherkapazitäten machen sie ideal für Unternehmen, die umfangreiche Rechenressourcen benötigen.

Vergleich der RTX 6000 ADA mit der NVIDIA H100

Die NVIDIA H100, basierend auf der Hopper-Architektur, ist derzeit die erste Wahl für groß angelegte KI-Einsätze. Sie bietet eine beispiellose Leistung mit bis zu 1978 TFLOPS Tensor-Verarbeitung, 80 GB HBM3-Speicher und 3.000 GB/s Bandbreite. Am wichtigsten ist, dass sie dank der NVLink-Technologie eine massive Multi-GPU-Skalierbarkeit in einem Rechenzentrum bietet.

Während die RTX 6000 ADA, basierend auf der Ada Lovelace-Architektur, eine robuste Leistung für einzelne Workstation-Aufgaben bietet, fehlt ihr die Skalierbarkeit und extreme Speicherbandbreite der H100, was die H100 zur überlegenen Wahl für die anspruchsvollsten KI-Anwendungen in Rechenzentren macht.

Fazit zur RTX 6000 ADA

Die NVIDIA RTX 6000 ADA GPU bietet erhebliche Vorteile gegenüber der A6000, mit mehr CUDA-Kernen, höheren TFLOPS und besserer Tensor-Leistung. Im Vergleich zur A100 und H100 glänzt sie in Workstation-Umgebungen, aber es fehlt ihr an der Skalierbarkeit und den Speicherfähigkeiten, die für groß angelegte Rechenzentrumseinsätze erforderlich sind.

Sie können zwischen festen und dynamischen Preisen wählen, wenn Sie RTX 6000 ADA-Instanzen auf der DataCrunch Cloud Platform bereitstellen.

Sie können zwischen festen und dynamischen Preisen wählen, wenn Sie RTX 6000 ADA-Instanzen auf der DataCrunch Cloud-Plattform bereitstellen.

Für KI-Forscher und Fachleute, die Hochleistungsrechnen in Workstations benötigen, ist die RTX 6000 ADA auch heute noch eine ausgezeichnete Wahl. Sie ist in der Lage, effizientes KI-Training, Inferenz und komplexe Simulationen durchzuführen.

Um herauszufinden, was Sie mit der RTX 6000 ADA erreichen können, starten Sie noch heute eine Instanz auf der DataCrunch Cloud-Plattform.