Stellen Sie sich eine leistungsstarke GPU vor, die entwickelt wurde, um die anspruchsvollsten Aufgaben in den Bereichen künstliche Intelligenz, maschinelles Lernen und High-Performance-Computing zu beschleunigen – das ist die NVIDIA RTX 6000 ADA. Diese mächtige GPU, die auf der revolutionären Ampere-Architektur basiert, bietet ein dynamisches Duo aus Tensor-Kernen und CUDA-Kernen, die in Harmonie zusammenarbeiten, um atemberaubende Leistungsniveaus für eine Vielzahl von KI- und maschinellen Lernanwendungen freizuschalten.

Sie ist mit fortschrittlichen KI-Fähigkeiten wie Deep Learning und neuronaler Netzwerkverarbeitung ausgestattet und bereit, die komplexesten Herausforderungen zu meistern. Die NVIDIA RTX 6000 ADA ist kompatibel mit einer Vielzahl von KI- und maschinellen Lern-Frameworks, Bibliotheken und Tools und ermöglicht es Forschern und Entwicklern, ihr volles Potenzial in ihren hochmodernen Projekten auszuschöpfen.

Die Ada Lovelace-Architektur von NVIDIA, die speziell für KI-Anwendungen entwickelt wurde, bietet beispiellose Leistung und Effizienz. Durch die Kombination von dritten RT-Kernen, vierten Tensor-Kernen und nächsten CUDA-Kernen revolutioniert sie die Kapazität für künstliche Intelligenz-Workloads. Die RTX 6000 ADA nutzt CUDA-Kerne für einen signifikanten Leistungsanstieg mit 18.176 Kernen im Vergleich zu den 10.752 Kernen ihres Vorgängers. Dritte RT-Kerne und Tensor-Kerne beschleunigen AI- und Deep-Learning-Aufgaben.

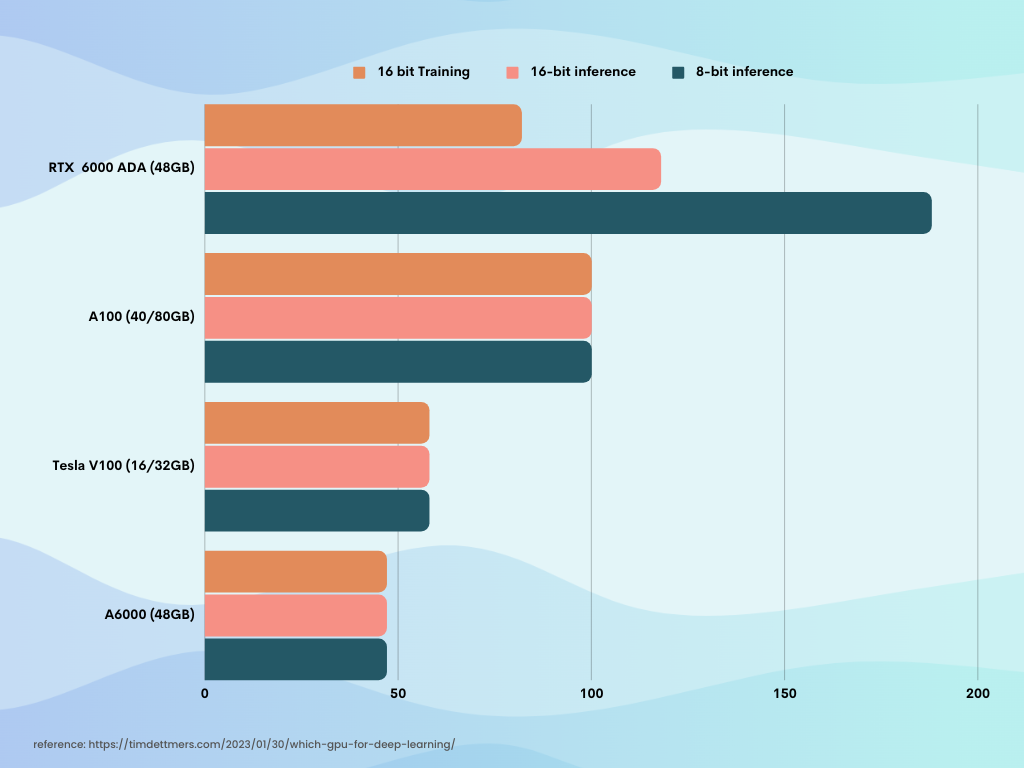

RTX 6000 ADA vs. andere Karten

Eigenschaft | RTX 6000 ADA | A6000 | Tesla V100 | A100 |

Architektur | ADA | Ampere | Volta | Ampere |

CUDA-Kerne | 18,176 | 10,752 | 5,120 | 6,912 |

Tensor-Kerne | 568 | 336 | 640 | 432 |

RT-Kerne | 142 | 84 | N/A | 72 |

Speicherkapazität | 48 GB GDDR6 | 48 GB GDDR6 | 16-32 GB HBM2 | 80 GB HBM2e |

Speicherbandbreite | 960 GB/s | 768 GB/s | 900 GB/s | 2,039 GB/s |

Single-Precision Leistung | 91.1 TFLOPS | 38.7 TFLOPS | 15.7 TFLOPS | 19.5 TFLOPS |

RT-Kern Leistung | 210.6 TFLOPS | 75.6 TFLOPS | N/A | 312 TFLOPS |

Tensor-Leistung | 1,457.0 TFLOPS | 309.7 TFLOPS | 125.0 TFLOPS | 1,248.0 TFLOPS |

*Eine aktualisierte Übersicht der Spezifikationen der RTX 6000 ADA anzeigen.

Warum DataCrunch für den Betrieb Ihrer RTX 6000 ADA nutzen?

Preismodell Wir sorgen dafür, dass Sie nie von unerwarteten Kosten überrascht werden. In der Welt der GPU-Hosting-Anbieter bieten wir eine ideale Kombination aus Zuverlässigkeit und Erschwinglichkeit. Mit einem transparenten Preismodell, das auf Prepaid-Credits und klaren Preisen basiert, können Sie sich von Sorgen über versteckte oder unerwartete Kosten verabschieden. Dies ermöglicht es Ihnen, sich auf das Wesentliche zu konzentrieren—das Wachstum Ihres Unternehmens, die Steigerung Ihrer AI/ML-Workloads und die Förderung von Innovationen—während Sie Ihr Budget gut im Griff behalten.

Einfach zu starten und zu testen, keine Verpflichtungen Während andere Anbieter ihre beste Hardware oft hinter großen Zahlungsverpflichtungen oder ausschließlich für Unternehmenskunden verbergen, bietet DataCrunch seine GPU-Instanzen und -Cluster jedem an, der die Leistung benötigt. Nutzen Sie sie als Spot-Instanz, On-Demand oder langfristig für dauerhaftere Workloads. Und das alles ohne die üblichen Einschränkungen, die andere Unternehmen setzen.

Fertig eingerichtete Notebooks wie Jupyter Möchten Sie ohne zusätzliche Einrichtung loslegen? Nutzen Sie unsere fertig eingerichteten Jupyter Notebook-Instanzen. Mit nur wenigen Klicks sind Sie startbereit. Sie kommen inklusive eines Einführungskurses von FastAI.