Die Wahl der richtigen GPU ist eine der wichtigsten Entscheidungen, die Sie treffen können, wenn Sie ein neues Deep-Learning-Projekt starten.

Noch vor ein paar Jahren wäre die RTX A6000 eine sichere Wahl gewesen. Heute hat diese GPU immer noch ihre Anwendungsbereiche, aber Sie sollten sich der neueren Alternativen wie der RTX 6000 Ada oder der H100 bewusst sein.

Warum sollten Sie die A6000 für Deep-Learning-Projekte in Betracht ziehen?

Im Jahr 2020 war die NVIDIA RTX A6000 eine der besten Optionen für Deep-Learning-Projekte. Mit 48 GB VRAM bot sie ausreichend Leistung, um anspruchsvolle ML-Aufgaben zu bewältigen – und sie stellte eine solide Alternative zu anderen Workstation-GPUs wie der RTX 3090 für Hochleistungsrechnen dar.

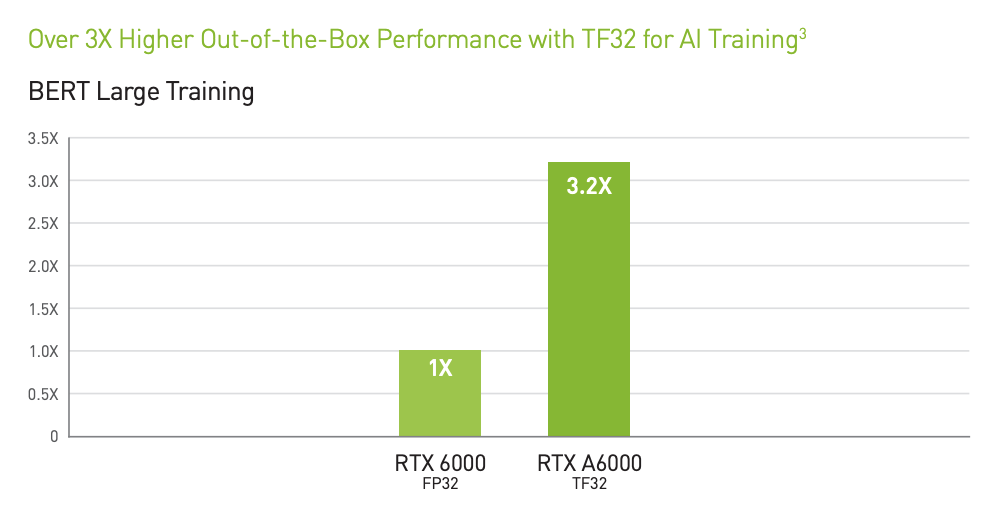

Die NVIDIA RTX A6000 wurde im Oktober 2020 als Teil von NVIDIAs professioneller Workstation-Reihe auf den Markt gebracht. Basierend auf der Ampere-GPU-Architektur brachte sie erhebliche Verbesserungen gegenüber ihrem Vorgänger, der RTX 6000, mit sich, wie zum Beispiel eine erhöhte Anzahl an CUDA Cores und die Einführung der dritten Generation von Tensor Cores. Das Ergebnis war das Versprechen von bis zu 3,2-mal besserem TF32-AI-Training im Vergleich zur RTX 6000.

Zum Zeitpunkt ihrer Markteinführung positionierte NVIDIA die RTX A6000 als die ultimative Workstation-GPU für Profis in den Bereichen KI, Data Science und Hochleistungsrechnen. Sie wurde als ideal für anspruchsvolle Arbeitslasten wie das Training großer neuronaler Netze, die Durchführung komplexer Simulationen und das Verwalten riesiger Datensätze beworben. Die Kombination aus 48 GB GDDR6-Speicher und einer Speicherbandbreite von 768 GB/s machte sie besonders geeignet für Aufgaben, die sowohl rohe Leistung als auch hohe Speicherkapazität erfordern.

Wechsel zu Datacenter-GPUs

Heute hat sich das Spiel in der KI-Schulung und -Inferenzen verändert. Die benötigte Rechenleistung zum Training großer KI-Modelle ist erheblich gestiegen. Infolgedessen hat NVIDIA neuere und leistungsstärkere GPUs wie die RTX 6000 Ada und die H100 auf den Markt gebracht. Diese neuen Modelle bieten eine bessere Preis-Leistungs-Verhältnis pro Watt, schnellere Verarbeitung und fortschrittlichere Netzwerkeigenschaften, die speziell für KI entwickelt wurden. Dies wirft die Frage auf: Ist die RTX A6000 immer noch eine gute Wahl, oder ist es an der Zeit, auf etwas Neueres umzusteigen? Um diese Frage zu beantworten, werfen wir zunächst einen Blick auf die Spezifikationen.

Vergleich der Spezifikationen: RTX A6000 vs. RTX 6000 Ada vs. H100

Im Folgenden vergleichen wir die RTX A6000, RTX 6000 Ada und H100 hinsichtlich der wichtigsten Spezifikationen: CUDA-Kerne, Tensor Cores, Speicherleistung und Preis.

GPU-Spezifikationen im Überblick

Spezifikation | RTX A6000 | RTX 6000 Ada | H100 |

|---|---|---|---|

Architektur | Ampere | Ada Lovelace | Hopper |

CUDA-Kerne | 10.752 | 18.176 | 16.896 |

Tensor Cores | 336 | 568 | 528 |

RT Cores | 84 | 142 | N/A (spezialisierte Kerne) |

Speicher | 48 GB GDDR6 | 48 GB GDDR6X | 80 GB HBM3 |

Speicherbandbreite | 768 GB/s | 960 GB/s | 2.048 GB/s |

Leistungsaufnahme | 300W | 350W | 700W |

Preis pro Stunde (ca.) | $1,01/h | $1,19/h | $3,17/h |

*Detailliertere Spezifikationen für RTX 6000 Ada und H100 anzeigen.

CUDA-Kerne und Tensor Cores

Die RTX 6000 Ada verdoppelt nahezu die Anzahl der CUDA-Kerne im Vergleich zur RTX A6000 und bietet 18.176 Kerne. Diese Steigerung führt zu schnelleren Berechnungen und einer besseren Leistung bei Aufgaben wie Deep Learning und Datenanalyse.

Auch die Tensor Cores sind entscheidend für KI-spezifische Operationen wie Matrizenmultiplikationen. Die RTX 6000 Ada übertrifft hier erneut die RTX A6000 mit 568 Tensor Cores im Vergleich zu 336 bei der A6000. Wenn Sie mit großen KI-Modellen arbeiten oder das Training beschleunigen müssen, ist dies ein bedeutendes Upgrade.

Die H100, mit ihren 528 Tensor Cores, liegt in diesem Bereich zwischen den beiden, bietet jedoch spezialisierte Kerne, die speziell für KI im großen Maßstab entwickelt wurden. Der wesentliche Unterschied besteht darin, dass die H100 weitaus bessere Netzwerkmöglichkeiten bietet, was bedeutet, dass Multi-GPU-Instanzen und Cluster von H100s eine weitaus überlegene Leistung gegenüber sowohl der RTX A6000 als auch der RTX 6000 Ada bieten.

Speicher und Bandbreite

Die Speicherleistung ist ein weiterer entscheidender Faktor, insbesondere wenn Sie mit großen Datensätzen oder komplexen Modellen arbeiten. Sowohl die RTX A6000 als auch die RTX 6000 Ada verfügen über 48 GB Speicher, aber das Ada-Modell verwendet GDDR6X, das schneller und effizienter ist als das GDDR6 der A6000. Auch die Speicherbandbreite der RTX 6000 Ada ist höher, mit 960 GB/s im Vergleich zu 768 GB/s bei der A6000, was schnellere Datenübertragung und -verarbeitung bedeutet.

Die H100 geht noch einen Schritt weiter und bietet 80 GB HBM3-Speicher mit einer enormen Bandbreite von 2.048 GB/s. Dies macht die H100 ideal für extrem datenintensive Aufgaben, wie das Training massiver Modelle oder das Ausführen von Simulationen, die viel Speicher und schnellen Zugriff darauf erfordern.

Leistungsaufnahme

Die RTX A6000 ist relativ energieeffizient und verbraucht 300W, was sie zu einer geeigneten Option macht, wenn der Energieverbrauch ein wichtiges Kriterium ist. Die RTX 6000 Ada benötigt etwas mehr Leistung bei 350W, liefert jedoch auch eine deutlich bessere Leistung pro Watt.

Die H100 hingegen ist ein energiehungriges Monster und verbraucht 700W. Diese GPU ist für Rechenzentren und groß angelegte KI-Operationen ausgelegt, bei denen der Energieverbrauch weniger wichtig ist als die reine Rechenleistung. Dennoch bietet die H100 in absoluten Zahlen eine gute Leistung pro Watt.

Eine bemerkenswerte Verwendung der RTX A6000 findet sich im Las Vegas Sphere. Laut NVIDIA werden etwa 150 A6000-GPUs eingesetzt, um die visuellen Darstellungen auf den 16x16K-Displays und 1,2 Millionen LED-Pucks der Sphere mit einer Auflösung von 16K und 60 Bildern pro Sekunde zu betreiben.

TFLOPS-Vergleich

Letztendlich lassen sich die Fähigkeiten der A6000 am besten durch ihre Floating-Point Operations per Second (FLOPS) vergleichen. Hier sehen Sie, wie sie im Vergleich zur Ada und zur SXM-Version der H100 abschneidet.

Spezifikation | RTX A6000 | RTX 6000 Ada | H100 (SXM) |

|---|---|---|---|

Single-Precision (FP32) | 38,7 TFLOPS | 91,1 TFLOPS | 67 TFLOPS |

Half-Precision (FP16) | 309,7 TFLOPS | 1.457 TFLOPS | 1.979 TFLOPS |

RTX A6000: Die RTX A6000 liefert 38,7 TFLOPS für Single-Precision Floating-Point-Operationen (FP32). Mit ihren Tensor Cores, die für KI-Arbeitslasten optimiert sind, kann die A6000 bis zu 309,7 TFLOPS bei gemischter Präzision (FP16) erreichen. Quelle: nvidia.com.

RTX 6000 Ada: Die RTX 6000 Ada erreicht bis zu 91,1 TFLOPS bei FP32-Berechnungen. Mit Tensor Cores kann die RTX 6000 Ada 1.457 TFLOPS bei FP16-Operationen erreichen. Quelle: nvidia.com.

H100 (SXM): Die H100 liefert 67 TFLOPS bei Single-Precision FP32. Bei FP16 erreicht die H100 mit Tensor Cores und Sparsity 1.979 TFLOPS. Quelle: nvidia.com.

Wann die RTX A6000 die richtige Wahl ist

Die RTX A6000 ist in der Lage, Deep-Learning-Arbeitslasten zu bewältigen, auch wenn sie nicht die Geschwindigkeit und Leistung der RTX 6000 Ada oder H100 erreicht. Dennoch kann sie viele kleinere Aufgaben im Bereich des Trainings von KI-Modellen und der Inferenz effizient erledigen.Hier sind einige Szenarien, in denen die RTX A6000 die beste Wahl für Sie sein könnte:

Training mittelgroßer Modelle

Wenn Sie an der Schulung von Modellen arbeiten, die groß, aber nicht riesig sind, können die 10.752 CUDA-Kerne und 336 Tensor Cores der RTX A6000 für Ihre Anforderungen ausreichen. Als NVIDIA-GPU kann die A6000 die meisten Deep-Learning-Frameworks effizient verarbeiten, was sie für Aufgaben wie Bilderkennung, natürliche Sprachverarbeitung und mehr geeignet macht.

KI-Inferenz und Bereitstellung

Wenn es um die Bereitstellung trainierter Modelle für Inferenzaufgaben geht—insbesondere in Umgebungen, in denen der Energieverbrauch und die Kosten eine Rolle spielen—ist die RTX A6000 eine ausgezeichnete Option. Sie bietet eine gute Leistung, während sie im Vergleich zu neueren Modellen energieeffizienter und kostengünstiger ist.

Allzweck-Computing

Über die KI hinaus ist die RTX A6000 auch vielseitig genug für andere GPU-intensive Aufgaben wie Videobearbeitung, 3D-Modellierung und Simulationen. Dies macht sie zu einer guten Wahl als Workstation-GPU, wenn Ihre Arbeit eine Mischung aus KI und anderen rechenintensiven Anwendungen umfasst.

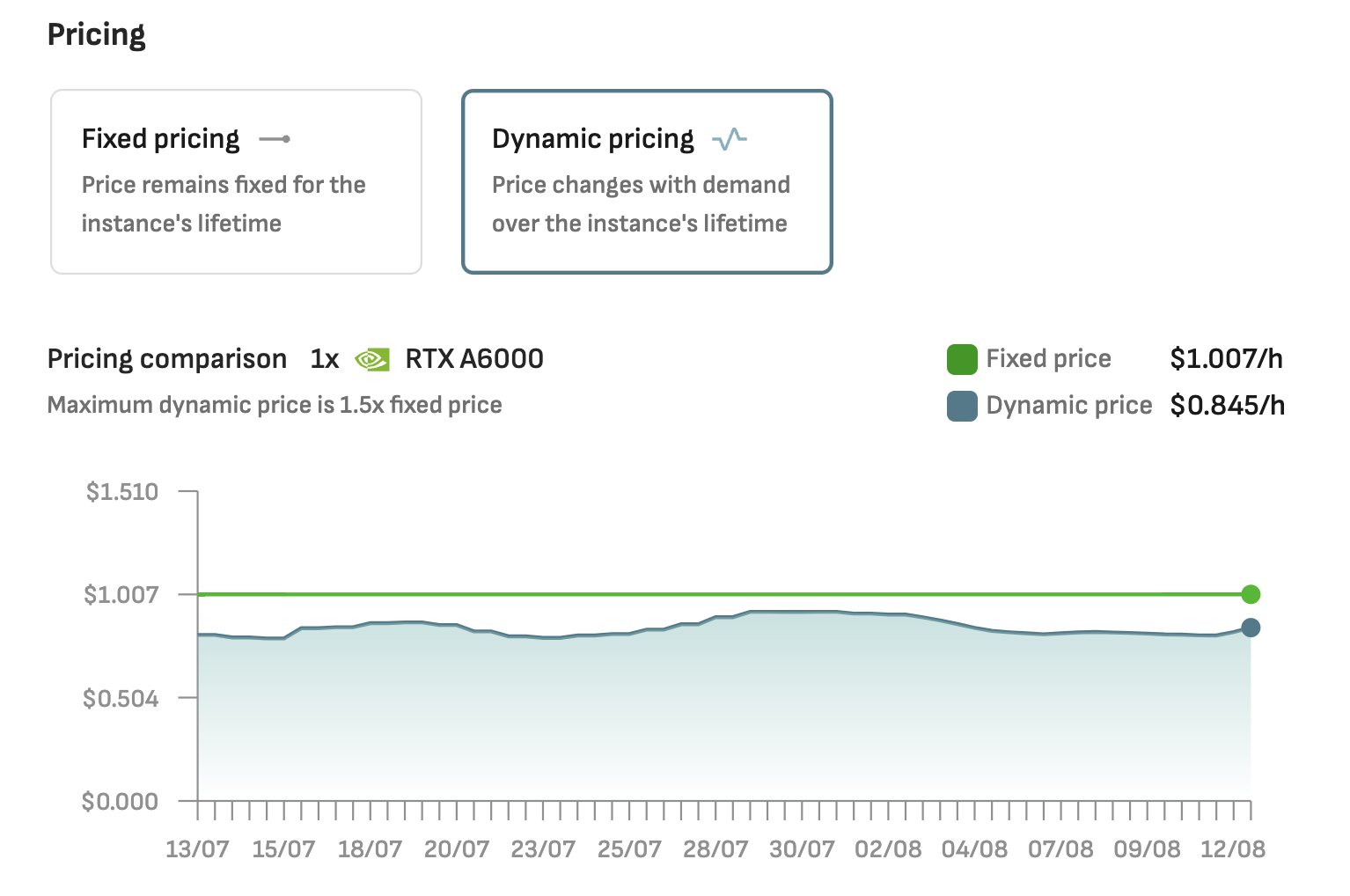

Gute Verfügbarkeit und kostengünstig als Cloud-GPU

Während der Preis der RTX A6000 seit 2020 erheblich gesunken ist, ist es wahrscheinlich keine kluge Entscheidung, diese GPU heute für Ihre Workstation zu kaufen. Es gibt neuere GPUs, die über die Lebensdauer des Geräts hinweg ein besseres Total Cost of Ownership (TCO) bieten können.Die gute Nachricht ist, dass die A6000 auf Cloud-GPU-Plattformen wie DataCrunch relativ gut verfügbar ist, sodass das Mieten der GPU einfach ist. Die Kosten pro Stunde, die Sie für den Zugriff auf diese GPU zahlen, sind wahrscheinlich niedriger als bei anderen ähnlichen Alternativen.Dieses Szenario macht die RTX A6000 zu einer attraktiven Wahl für Cloud-basierte Projekte, bei denen Kostenkontrolle und Zugänglichkeit entscheidend sind, während sie dennoch ausreichend Leistung für viele KI- und GPU-intensive Aufgaben bietet.

In Bezug auf die Preisgestaltung ist die RTX A6000 eine der erschwinglichsten Optionen, mit einem ungefähren Stundenpreis von $1,01/h auf der DataCrunch Cloud-Plattform. Der Stundenpreis der RTX 6000 Ada von $1,19/h spiegelt ihre fortschrittlicheren Fähigkeiten und ihre überlegene Leistung pro GPU wider. Von den drei Optionen ist die H100 die teuerste, mit Kosten von $3,17/h pro GPU-Instanz. Viele KI-Entwickler entscheiden sich dennoch dafür, für diese Premium-Option zu zahlen, um die maximale Leistung zu erhalten.

Fazit zur RTX A6000 heute

Heute bleibt die RTX A6000 eine zuverlässige und kostengünstige Option, insbesondere wenn Sie an mittelgroßen KI-Projekten arbeiten oder eine vielseitige GPU benötigen, die eine Mischung aus KI- und allgemeinen Rechenaufgaben bewältigen kann. Ihre Erschwinglichkeit pro Stunde, die breitere Verfügbarkeit und die Energieeffizienz machen sie zu einer attraktiven Wahl für kleinere Teams, Startups oder einzelne KI-Ingenieure, die budgetbewusst sind, aber dennoch eine solide Leistung benötigen.

Diese Eigenschaften machen die RTX A6000 zu einer lohnenden Wahl für diejenigen, die eine Balance zwischen Kosten und Leistung suchen, insbesondere in Szenarien, in denen neuere GPUs wie die RTX 6000 Ada und H100 möglicherweise überdimensioniert sind oder das Budget sprengen würden.