Wenn du planst, virtuelle Maschinen für dein nächstes AI-Training oder Inferenzprojekt bereitzustellen, hast du vielleicht bemerkt, dass der Markt für Cloud-GPUs im Moment ein ziemlich wilder Ort ist. 🤠

Sowohl Hyperscaler als auch neue, auf AI spezialisierte Startups kämpfen erbittert um den Zugang zu den neuesten, erstklassigen Cloud-GPUs. Die Kosten für GPU-Instanzen und -Cluster variieren stark zwischen den verschiedenen Anbietern. Es ist nicht einfach, sich einen klaren Überblick über deine Optionen zu verschaffen. Deshalb sind wir hier, um dir zu helfen.

In diesem Artikel gehen wir einige der gängigen Optionen für den Einsatz von Cloud-GPU-Instanzen durch, darunter Google Cloud Platform, Amazon AWS und Microsoft Azure. Wir bewerten auch drei der bekanntesten Cloud-Computing-Anbieter – OVH, Scaleway und Paperspace – und stellen dir DataCrunch als eine neue Option vor, die du in Betracht ziehen solltest.

Preise für Cloud-GPU-Hyperscaler

Viele AI-Entwickler wenden sich zuerst an Hyperscaler wie Google oder Amazon, wenn sie mit ihrer Cloud-Computing-Reise beginnen. Diese Option ergibt Sinn, da viele bereits in der Vergangenheit mit einer bevorzugten Cloud-Computing-Plattform gearbeitet haben und wissen, wie sie funktioniert. Es ist auch nicht ungewöhnlich, dass die großen Anbieter Startups eine beträchtliche Menge an kostenlosen Guthaben für AI-bezogene Projekte anbieten. Glückwunsch, wenn du deine Credits erhalten hast – so kannst du sie nutzen!

Preise für GPUs auf der Google Cloud Platform

Die Google Cloud Platform bietet virtuelle Maschinen für Machine-Learning-Anwendungen über die Compute Engine Lösung an. Jede GPU, die GCP anbietet, hat eine interne Modellbezeichnung, wie zum Beispiel a3-highgpu-8g. Zudem hast du die Wahl zwischen mehreren internationalen Rechenzentrumsstandorten.

GPU | Speicher | Maschinentyp | Region | Preis pro Stunde |

|---|---|---|---|---|

H100 | 80GB | a3-highgpu-1g | us-central1 | Nicht verfügbar |

H100 x8 | 80 GB | a3-highgpu-8g | europe-west4 | 88,49 $ |

A100 | 80 GB | a2-ultragpu-1g | europe-west4 | 5,58 $ |

A100 x2 | 80 GB | a2-ultragpu-2g | europe-west4 | 11,12 $ |

A100 x4 | 80 GB | a2-ultragpu-4g | europe-west4 | 22,32 $ |

A100 x8 | 80GB | a2-ultragpu-8g | europe-west4 | 44,65 $ |

A100 | 40 GB | a2-highgpu-1g | europe-west4 | 3,78 $ |

A100 x2 | 40 GB | a2-highgpu-2g | europe-west4 | 7,49 $ |

A100 x4 | 40 GB | a2-highgpu-4g | europe-west4 | 14,99 $ |

A100 x8 | 40GB | a2-highgpu-8g | europe-west4 | 29,98 $ |

Derzeit wird die NVIDIA H100 von GCP nur auf einer 8-GPU-Instanz in der Region us-central1 für 88,49 $ pro Stunde angeboten. Die Google Cloud Platform bietet viele verschiedene Optionen für die 80GB und 40GB Versionen der A100 an.

Google bietet auch ältere Cloud-GPU-Optionen an, darunter die NVIDIA V100 Tensor Core GPU zu einem Preis von 2,48 $ pro GPU für bis zu 8x V100-Instanzen. Im direkten Vergleich war GCP etwas günstiger als Amazon AWS und Microsoft Azure.

Maschinentyp | GPU | Speicher | Region | Preis pro Stunde |

|---|---|---|---|---|

nvidia-tesla-v100-1g | V100 | 16 GB | europe-west4-b | 2,48 $ |

nvidia-tesla-v100-2g | V100 x2 | 32 GB | europe-west4-b | 4,96 $ |

nvidia-tesla-v100-4g | V100 x4 | 64 GB | europe-west4-b | 9,92 $ |

nvidia-tesla-v100-8g | V100 x8 | 128 GB | europe-west4-b | 19,84 $ |

Weitere Informationen und aktuelle Kosten findest du unter GCP Compute Pricing.

Preise für GPUs auf Amazon AWS

Amazon bietet über AWS EC2 eine Reihe von Cloud-GPUs an. Jede virtuelle Maschine hat ihre eigene Amazon-Modellbezeichnung für Instanztypen, z.B. „p5.48xlarge“. Diese AWS-Instanzbezeichnungen können etwas Zeit in Anspruch nehmen, um entschlüsselt zu werden. Hier ist eine kurze Übersicht über die verschiedenen Optionen.

Modell | GPU | GPU-Speicher | Region | Preis pro Stunde |

|---|---|---|---|---|

p5e.48xlarge | H200 x8 | 1128 GB | Nicht verfügbar | N/A |

p5.48xlarge | H100 x8 | 640 GB | 98,32 $ | |

p4d.24xlarge | A100 40GB x8 | 320 GB | 32,77 $ | |

p4de.24xlarge | A100 80GB x8 | 640 GB | Nicht verfügbar | N/A |

p3.2xlarge | V100 x1 | 16 GB | 3,06 $ | |

p3.8xlarge | V100 x4 | 64 GB | 12,24 $ | |

p3.16xlarge | V100 x8 | 128 GB | 24,48 $ |

Die H100 wird derzeit nur in 8-GPU-Instanzen zu einem Preis von 98,32 $ pro Stunde angeboten. AWS bietet nur 40-GB-Versionen der A100 für 32,77 $ für eine 8x-GPU-Instanz an.

Amazon hat mehrere Optionen für die V100 im Angebot, von 1x bis 8x GPU-Instanzen in verschiedenen AWS EC2-Regionen, die bei 3,06 $ pro GPU oder 24,48 $ für eine 8xV100-Instanz beginnen.

Obwohl sie Instanzmodelle gelistet haben, sind die H200 und A100 80GB derzeit nicht über AWS verfügbar.

Preise für GPUs auf Microsoft Azure

Microsoft Azure bietet eine Reihe von Hochleistungs-Cloud-GPUs in verschiedenen internationalen Rechenzentrumsstandorten an.

Instanzname | GPU | GPU-Speicher | Region | Preis pro Stunde |

|---|---|---|---|---|

NC40ads H100 v5 | H100 | 80GB | East US | 6,98 $ |

NC80adis H100 v5 | H100 x2 | 160 GB | East US | 13,96 $ |

NC24ads A100 v4 | A100 80GB | 80GB | East US | 3,67 $ |

NC48ads A100 v4 | A100 80GB x2 | 160 GB | East US | 7,35 $ |

NC96ads A100 v4 | A100 80GB x 4 | 320 GB | East US | 14,69 $ |

NC6s v3 | V100 | 32 GB | East US | 3,06 $ |

NC12s v3 | V100 x2 | 64 GB | East US | 6,12 $ |

NC24rs v3 | V100 x4 | 128 GB | East US | 12,24 $ |

Derzeit wird die H100 für 6,98 $ pro GPU-Instanz angeboten, und die A100 ist in verschiedenen Konfigurationen erhältlich, von 3,67 $ für eine einzelne GPU bis zu 14,69 $ für 4xA100-Instanzen.

Für die V100 gibt es ebenfalls viele Optionen, die von 3,06 $ pro Stunde bis zu 12,24 $ für eine 4xV100-Instanz reichen.

Zusätzlich zu Windows kannst du auf deiner Azure-Virtual-Machine-Instanz auch Ubuntu und andere Linux-Betriebssysteme ausführen. Aktuelle Preisinformationen zu Microsoft Azure findest du unter Linux Virtual Machine Pricing.

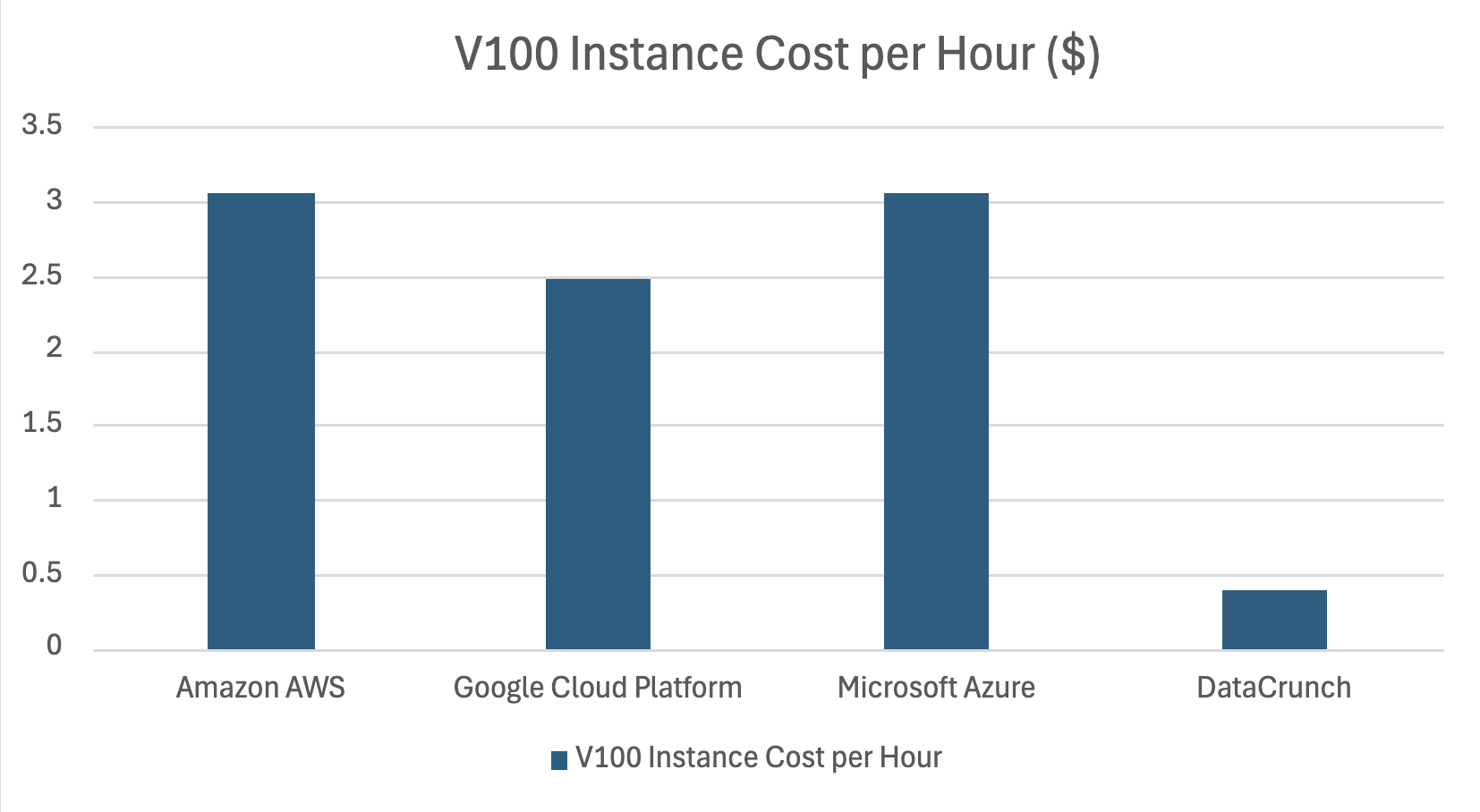

Vergleich der GPU-Kosten: GCP vs. Amazon AWS vs. Azure

Es ist nicht einfach, die Cloud-GPU-Preise von Amazon AWS, Google Cloud Platform und Microsoft Azure genau zu vergleichen, da das Angebot an GPU-Instanzen nicht stark überlappt. Alle drei Anbieter bieten jedoch derzeit die V100 zu ähnlichen Preisen an, wobei Amazon AWS und Azure den exakt gleichen Preis von 3,06 $ pro Stunde anbieten.

Was sind deine anderen Optionen?

Neben Google, Amazon und Microsoft gibt es weitere Optionen, die im Bereich der Hyperscaler in Betracht gezogen werden können. Enterprise-IT-Unternehmen wie Oracle, IBM und HP bieten ebenfalls ein gewisses Maß an Cloud-Computing-Kapazitäten an. Um eine genaue Preisübersicht zu erhalten, musst du sie möglicherweise direkt kontaktieren.

Wenn du einfach nur eine kostengünstige Option suchst, wirst du bei Amazon, Google, Microsoft oder anderen Hyperscalern wahrscheinlich nicht das beste Angebot finden. Auf AI spezialisierte Cloud-GPU-Anbieter wie DataCrunch bieten die gleichen Hochleistungs-GPUs bis zu 8x günstiger an. Zum Beispiel kostet die V100 auf der DataCrunch Cloud Platform derzeit nur 0,39 $ pro Stunde, und die H100 ist für 3,35 $/Stunde erhältlich.

Cloud-Computing-Anbieter

Wenn du über die Hyperscaler hinausblicken möchtest, gibt es eine Reihe etablierter, großer Cloud-Computing- und Hosting-Anbieter, die GPU-virtuelle Maschinen anbieten. Drei der am häufigsten in Betracht gezogenen Optionen sind OVH, Paperspace und Scaleway.

OVHcloud GPU-Preise

OVHcloud ist Europas größter Cloud-Computing-Anbieter. Mit Hauptsitz in Frankreich betreut OVH Kunden auf der ganzen Welt und verfügt über Rechenzentren an mehreren internationalen Standorten. Neben verschiedenen CPU-VM-Instanzen bietet OVHcloud auch bedarfsgesteuerte Instanzen beliebter Cloud-GPUs an.

Instanzname | GPU | GPU-Speicher | Preis pro Stunde |

|---|---|---|---|

h100-380 | H100 | 80 GB | 2,99 $ |

h100-760 | H100 x2 | 160 GB | 5,98 $ |

h100-1520 | H200 x4 | 320 GB | 11,97 $ |

a100-180 | A100 | 80 GB | 3,07 $ |

a100-360 | A100 x2 | 160 GB | 6,15 $ |

a100-720 | A100 x4 | 320 GB | 12,29 $ |

t1-45 | V100 | 16 GB | 1,97 $ |

l1-90 | V100 x2 | 32 GB | 3,94 $ |

t1-180 | V100 x4 | 64 GB | 7,89 $ |

l40s-90 | L40S | 48 GB | 1,80 $ |

l40s-180 | L40S x2 | 96 GB | 3,60 $ |

l40s-360 | L40S x4 | 192 GB | 7,20 $ |

OVHcloud bietet leistungsstarke NVIDIA-Instanzen in verschiedenen Konfigurationen und Optionen an. Es ist der einzige Cloud-GPU-Anbieter, der die H100 zu einem niedrigeren Stundenpreis als die A100 anbietet.

OVHcloud bietet außerdem mehrere Instanzen der V100 und L40S an sowie dedizierte Server und Datenhosting-Dienste.

Aktuelle Preise von OVH findest du hier.

Paperspace GPU-Preise

Paperspace ist eine bedeutende Cloud-Computing-Plattform, die sich auf den Einsatz von Machine-Learning-Modellen spezialisiert hat und zu Digital Ocean gehört, einem Webhosting-Unternehmen.

Paperspace bietet Multi-GPU-Instanzen der H100, A100 und V100 an. Darüber hinaus bieten sie verschiedene auf RTX basierende GPUs auf Abruf an, darunter die RTX A6000, RTX 5000 und RTX 4000.

Der aktuelle Stundenpreis für eine H100-GPU-Instanz bei Paperspace beträgt 5,95 $, es werden jedoch Rabatte bei mehrjährigen Verträgen angeboten.

GPU | GPU-Speicher | Preis pro Stunde |

H100 | 80 GB | 5,95 $ |

H100 x8 | 640 GB | 47,60 $ |

A100 x8 | 640 GB | 25,44 $ |

V100 | 32 GB | 2,30 $ |

V100 x2 | 64 GB | 4,60 $ |

V100 x4 | 128 GB | 9,20 $ |

RTX A6000 | 48 GB | 1,89 $ |

Weitere Informationen zu den Preisen von Paperspace findest du hier.

Scaleway GPU-Preise

Scaleway ist ein weiteres großes Webhosting- und Cloud-Computing-Unternehmen mit Sitz in Frankreich und einer Präsenz an vielen internationalen Standorten. Ähnlich wie OVHcloud bietet Scaleway eine breite Palette virtueller Maschinen und Cloud-Speicheroptionen, einschließlich Cloud-GPU-Instanzen.

Instanzname | GPU | GPU-Speicher | Preis pro Stunde |

H100-1-80G | H100 | 80 GB | 2,73 $ |

H100-2-80G | H100 x2 | 160 GB | 5,46 $ |

L40S-1-48G | L40S | 48 GB | 1,40 $ |

L40S-2-48G | L40S x2 | 96 GB | 2,80 $ |

L40S-4-48G | L40S x4 | 192 GB | 5,60 $ |

L40S-8-48G | L40S x8 | 384 GB | 11,20 $ |

Scaleway bietet derzeit einen der niedrigsten Stundenpreise für die H100 Instanz unter den großen Cloud-GPU-Anbietern. Darüber hinaus bieten sie auch L40S und P100-Instanzen an.

Scaleway bietet außerdem dedizierte Server und Bare-Metal-Lösungen an.

Weitere Informationen zu den aktuellen Scaleway-GPU-Preisen findest du hier.

Preise für DataCrunch Cloud GPUs

Wenn du bereit bist, mit neuen Cloud-GPU-Anbietern zusammenzuarbeiten, solltest du DataCrunch in Betracht ziehen. Wir repräsentieren eine neue Generation von AI-fokussierten, beschleunigten Computing-Plattformen, die von AI-Ingenieuren für AI-Ingenieure entwickelt wurden.

Wir arbeiten ausschließlich mit hochwertigen NVIDIA Cloud-GPUs und legen Wert auf Geschwindigkeit, Kosteneffizienz und Effizienz sowohl in der Hardware als auch in der Software. In einigen Fällen konnten wir die Kosten für AI-Inferenz um 70 % senken, indem wir einfach mehr Effizienz aus der NVIDIA-Hardware herausgeholt haben.

Im direkten Kostenvergleich sind unsere festen Stundensätze für GPU-Instanzen wettbewerbsfähig. Zudem sind wir die erste Cloud-GPU-Plattform, die dynamische Preise anbietet – eine neue Möglichkeit, die Kosten für AI-fokussiertes Computing durch die Nutzung unserer weniger ausgelasteten Bestände zu senken.

So funktioniert die dynamische Preisgestaltung: Wenn wir über Kapazitäten in unseren GPU-Modellen verfügen, wie z. B. im Beispiel der RTX 6000 ADA unten, bieten wir einen ermäßigten Stundensatz für GPU-Instanzen an. Du kannst bis zu 40 % der Kosten für GPU-Instanzen sparen, indem du dynamische Preise anstelle eines Festpreises zu Nebenzeiten und bei GPUs mit weniger Wettbewerb wählst.

Bei DataCrunch zeichnen wir uns nicht nur durch unsere flexiblen und fairen Preise aus. Unsere Rechenzentren nutzen 100 % erneuerbare Energie und bieten Sicherheit auf Unternehmensniveau. Oft werden wir für den erstklassigen Service gelobt, den wir unseren Kunden bieten.

Der beste Weg, um herauszufinden, ob DataCrunch die richtige Option für dich ist, besteht darin, eine Instanz auf unserer intuitiven und benutzerfreundlichen GPU-Cloud-Plattform zu starten.

Um ein noch besseres Angebot zu erhalten, kannst du uns gerne kontaktieren, um ein Angebot für Bare-Metal-Cluster oder serverlose Inferenzlösungen anzufordern.

Alle hier angegebenen Preis- und Kosteninformationen sind ab September 2024 aktuell. Wenn du Fehler findest, kannst du uns gerne auf Reddit oder X kontaktieren.