Wenn Sie nach Hardware suchen, um anspruchsvolle KI-Workloads auszuführen, werden Sie höchstwahrscheinlich zwischen verschiedenen Hardwareoptionen von NVIDIA wählen. Es gibt keinen anderen Anbieter, der Ihnen die volle Leistung, Netzwerkinfrastruktur und Software-Stack bieten kann.

Für größere KI-Trainings- und Inferenzprojekte müssen Sie Optionen zwischen dem Aufbau oder der Bereitstellung von Multi-GPU-Systemen in Betracht ziehen. Hier stehen Sie vor der Wahl zwischen HGX- und DGX-Serverkonfigurationen. Lassen Sie uns einige grundlegende Unterschiede und die Auswirkungen auf größere KI-Workloads durchgehen.

Was ist NVIDIA DGX?

NVIDIA DGX ist die vorgefertigte All-in-One-KI-Computing-Plattform von NVIDIA, die für Organisationen entwickelt wurde, die eine leistungsstarke und einfach bereitzustellende Lösung für schwere KI- und Machine-Learning-Workloads benötigen. Denken Sie an DGX als die Plug-and-Play-Option für Unternehmen, bei der alles vorkonfiguriert geliefert wird – Hardware, Software-Stack und Diagnosetools.

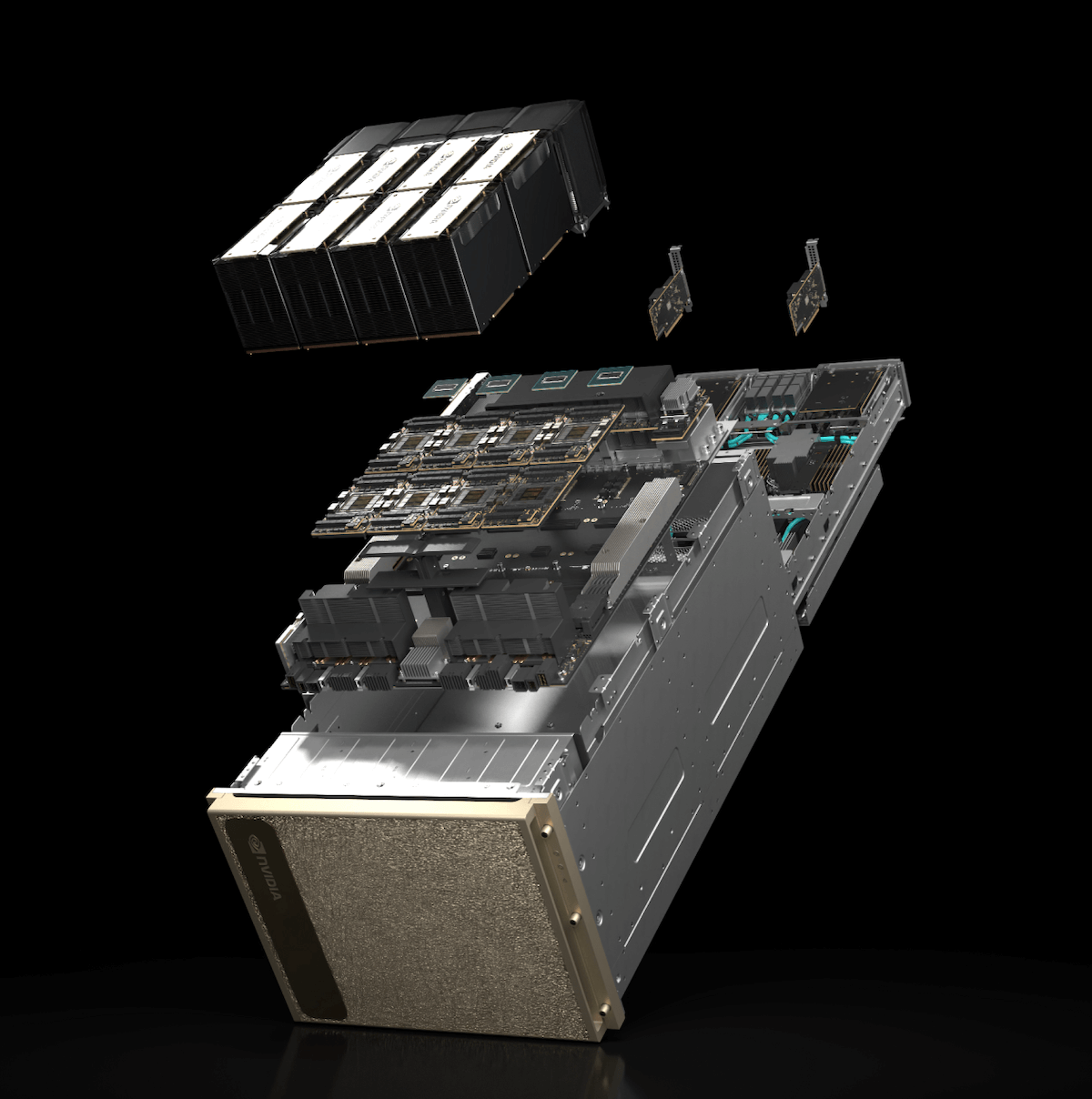

Komponenten im DGX H200-System. Quelle: nvidia.com

Jedes DGX-System wird mit bis zu 8 vorinstallierten NVIDIA-GPUs geliefert, wie der H100 oder H200, sowie mit der NVLink-Interconnect-Technologie, die eine effiziente Kommunikation zwischen den GPUs ermöglicht.* DGX unterstützt den Kernsoftware-Stack von NVIDIA, einschließlich Tools wie CUDA, cuDNN, TensorRT und voroptimierten KI-Frameworks von NVIDIA NGC. Sie sollten das DGX-System als eine einheitliche Plattform betrachten, die sowohl Hardware als auch Software für eine schnelle Bereitstellung kombiniert.

*Sieh dir einen detaillierteren Vergleich der H100- und H200-CPUs an.

Wichtige Merkmale der DGX-Systeme

Schlüsselfertige Lösung: DGX kommt vorkonfiguriert und erfordert minimalen Setup-Aufwand.

Erweiterte GPU-Konfigurationen: Bis zu acht H100 Tensor Core-GPUs, die effizient in jedes System integriert sind.

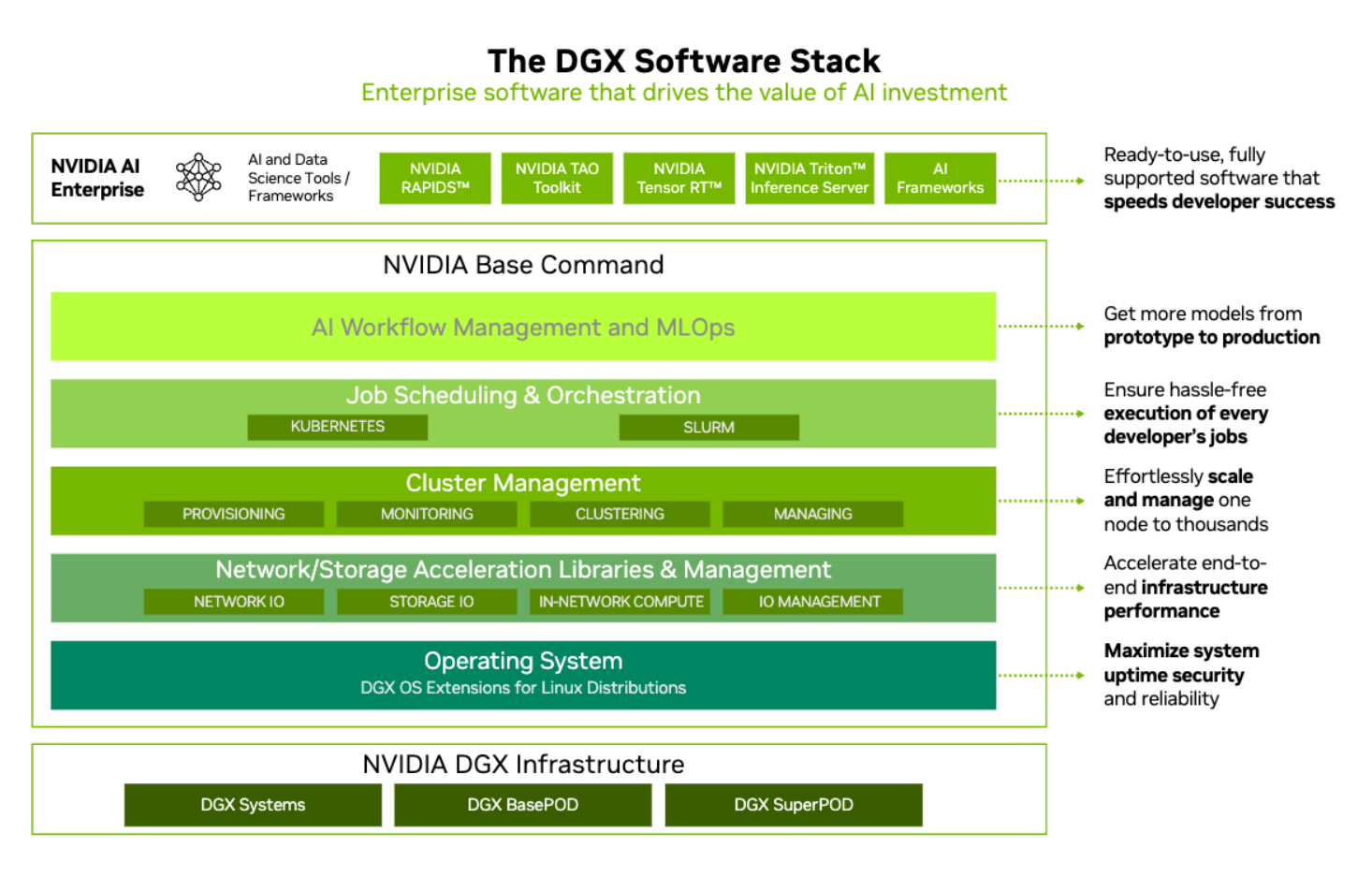

NVIDIA Software-Stack: Einfache Nutzung der KI-Bibliotheken, Tools und Frameworks von NVIDIA, einschließlich NVIDIA Base Command, der Cluster-Management-Software für DGX-Rechenzentren.

Unternehmenssupport: DGX bietet zusätzliche Dienstleistungen und Support für Unternehmensanwender.

Wer sollte DGX verwenden?

DGX-Systeme richten sich hauptsächlich an Unternehmenskunden. Sie sind ideal, wenn Sie eine vorgefertigte KI-Lösung mit minimaler Einrichtungszeit und Netzwerkkonfiguration suchen. Sie könnten gut zu Forschungseinrichtungen, Startups mit Fokus auf KI-Entwicklung oder Unternehmen passen, die KI-getriebene Geschäftsstrategien verfolgen.

Was ist NVIDIA HGX?

Im Gegensatz zu DGX ist NVIDIA HGX kein vorkonfiguriertes System. Es handelt sich stattdessen um eine modulare Plattform, die die Bausteine bietet, um skalierbare KI-Infrastrukturen zu entwerfen und bereitzustellen. Mit HGX können Sie die Leistung durch die Integration mehrerer NVIDIA-GPUs (wie der A100 oder H100) auf eine extrem schnelle und effiziente Weise skalieren.

HGX H200-System mit NVLink-Switch-Chips. Quelle: nvidia.com

HGX ist auf die Anforderungen von Rechenzentren zugeschnitten und integriert fortschrittliche GPU-Konfigurationen, Netzwerk-Interconnects und Speicherlösungen. Dies bedeutet, dass Endkunden selten komplette HGX-Systeme kaufen, es jedoch eine ausgezeichnete Option für Cloud-Anbieter und große Unternehmen ist, die hoch skalierbare, maßgeschneiderte Infrastrukturen für KI-Workloads benötigen.

Wichtige Merkmale der HGX-Systeme

Modulare Flexibilität: Im Gegensatz zu DGX bindet HGX Sie nicht an eine spezifische Konfiguration. Sie können das System basierend auf Ihren Leistungs- und Skalierbarkeitsanforderungen entwerfen und optimieren.

Hochdichte GPU-Bereitstellung: HGX-Systeme unterstützen massive GPU-Skalierungen, was sie ideal für groß angelegte KI-Trainings und Inferenzaufgaben oder Hochleistungsrechner (HPC) macht.

Anpassbare Netzwerk- und Speicherlösungen: Sie können fortschrittliche Netzwerklösungen (z. B. InfiniBand, NVLink) und Speicherkonfigurationen auswählen, um für hochdurchsatzstarke Datenumgebungen zu optimieren.

Integration in Rechenzentren: HGX ist perfekt für die Integration in bestehende Rechenzentren geeignet und ermöglicht es, die Rechenressourcen je nach Workload-Anforderung zu skalieren.

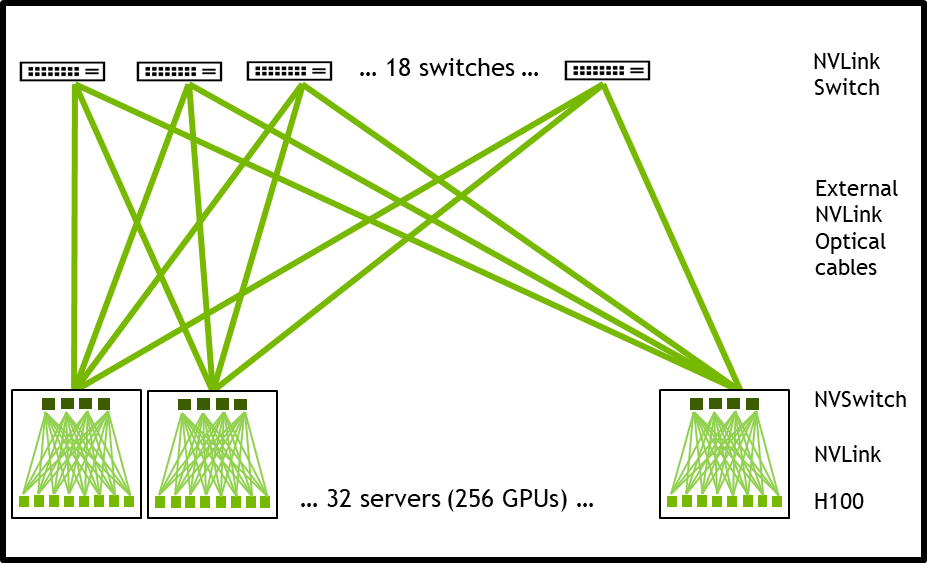

Visuelle Darstellung eines NVIDIA H100 HGX-Systems mit 256 GPUs. Quelle: nvidia.com

Wer sollte HGX verwenden?

HGX ist ideal für groß angelegte Rechenzentrumskonfigurationen. Hyperscaler, Cloud-Anbieter und große Unternehmen, die große HPC-Umgebungen (High-Performance Computing) aufbauen oder erweitern möchten, nutzen die Flexibilität von HGX, um sich an spezifische Workload-Anforderungen anzupassen und im Laufe der Zeit immer größere Computing-Cluster zu erstellen.

Technischer Vergleich: DGX vs. HGX

Hardware-Vergleich

Beim Vergleich von DGX und HGX vergleichen Sie im Wesentlichen ein schlüsselfertiges System mit einer flexiblen, modularen Lösung. Beide Systeme verwenden die neuesten GPUs von NVIDIA, aber der Bereitstellungsansatz unterscheidet sich erheblich.

DGX-Systeme: Ein typisches DGX H100-System enthält acht H100 Tensor Core-GPUs, die über NVLink verbunden sind, was eine hochbandbreitige Kommunikation zwischen den GPUs ermöglicht. Es umfasst außerdem Hochleistungsspeicher und Netzwerkinfrastrukturen, die alle sofort einsatzbereit konfiguriert sind.

HGX-Systeme: Bei HGX haben Sie mehr Freiheit. Sie können wählen, wie viele GPUs (bis zu 16 oder mehr pro Server) integriert werden sollen, und deren Verbindungen (über NVLink, PCIe oder InfiniBand) so konfigurieren, dass sie entweder auf Leistung oder Kosten optimiert sind. HGX bietet Ihnen die Flexibilität, Ihre Umgebung nach Bedarf zu skalieren, während DGX-Systeme auf vordefinierte Konfigurationen beschränkt sind.

Software-Ökosystem

Mit DGX erhalten Sie einen vollständig integrierten Software-Stack, der NVIDIA Base Command und den Zugriff auf NVIDIA NGC für optimierte KI-Container umfasst. DGX ist so konzipiert, dass es nahtlos mit den KI-Bibliotheken und Frameworks von NVIDIA integriert wird und den Prozess zur Ausführung komplexer KI-Workflows vereinfacht.

HGX hingegen bietet Ihnen mehr Kontrolle über die Softwareumgebung. Sie können benutzerdefinierte KI-Frameworks, Orchestrierungs-Tools wie Kubernetes und cloud-native Dienste integrieren. Dadurch ist HGX besser geeignet für alle, die eine tiefgehende Anpassung ihrer KI-Workloads benötigen und es bevorzugen, ihren eigenen Software-Stack zu verwalten.

Bereitstellungsflexibilität

Wenn Sie ein Gamer sind, können Sie sich DGX wie einen Alienware-PC vorstellen. Es kommt mit wirklich guter vorinstallierter Hardware und Software, aber Ihre Möglichkeiten, Änderungen vorzunehmen, sind begrenzt. Ein HGX-System hingegen ist wie ein selbstgebauter Gaming-PC. Sie haben volle Flexibilität bei der Wahl der Hardware und Software und können diese im Laufe der Zeit nach Ihren Bedürfnissen anpassen.

DGX: Am besten für Single-Node-Installationen, die sofort bereitgestellt werden müssen, insbesondere wenn Sie die Einrichtungszeit minimieren möchten. DGX-Systeme lassen sich schnell bereitstellen und eignen sich besonders gut für eigenständige Forschungslabors oder KI-Teams in Unternehmen mit begrenztem IT-Support.

HGX: Bietet Flexibilität bei der Integration von KI-Funktionen in groß angelegte Rechenzentren. HGX glänzt, wenn Sie Ihre Infrastruktur über mehrere Knoten oder Regionen hinweg anpassen und skalieren müssen.

Leistung und Benchmarking

Die DGX H200- und HGX H200-Maschinen verwenden beide dieselbe H200 SXM-Basisplatine und bieten daher die exakt gleiche GPU-Leistung, solange CPU und Systemspeicher nicht ins Spiel kommen. Die CPUs und der Systemspeicher haben jedoch oft einen erheblichen Einfluss auf die Gesamtleistung, da sie entscheidend dafür sind, die GPUs mit Daten zu versorgen.

DGX H200 | DataCrunch HGX H200 |

|---|---|

GPU | 8x H200 SXM5 141GB |

CPU | 2x Intel 8480C - 224 Threads |

CPU-relative Leistung (passmark) | 125165 - 100% |

Speicher | 2TB |

Speicherbandbreite | 306GB/s |

Kostenüberlegungen

Die Kosten eines DGX-Systems sind einfach zu verstehen – es gibt einen festen Preis für das gesamte System, das Hardware, Software, Schulungen und Support umfasst. HGX hingegen verwendet ein detaillierteres Preismodell, das von der Wahl des OEM und den Konfigurationspräferenzen abhängt. Typischerweise kaufen Sie keine HGX-Systeme direkt von NVIDIA. Sie müssen die Kosten der einzelnen Komponenten – GPUs, Speicher, Netzwerk – sowie Software- und Supportverträge berücksichtigen.

Die große Frage, die Sie sich stellen müssen, bevor Sie sich für eine der beiden Optionen entscheiden, ist, ob Sie überhaupt eine anfängliche Investition in Hardware tätigen müssen. Cloud-GPU-Plattformen wie DataCrunch bieten wettbewerbsfähige Stundentarife für GPU-Instanzen und maßgeschneiderte Bereitstellungen der neuesten NVIDIA-GPU-Cluster. Sollten Sie Zweifel haben, können Sie sich direkt an unsere KI-Ingenieure wenden, um eine effiziente Konfiguration für Ihre Anforderungen zu besprechen.

Fazit: DGX vs. HGX

Die Wahl zwischen DGX und HGX hängt letztlich von Ihren Infrastrukturbedürfnissen, dem Bereitstellungsumfang und den technischen Ressourcen ab. Wenn Sie nach einer Plug-and-Play-Lösung mit minimaler Einrichtung und einfacher Verwaltung suchen, bietet DGX eine leistungsstarke und zuverlässige Option. Wenn Sie jedoch Anpassungsfähigkeit und Skalierbarkeit benötigen und über die Infrastruktur verfügen, um eine flexible KI-Plattform zu unterstützen, ist HGX die bessere Wahl.

Die Bereitstellung von Hardware für KI-Workloads ist keine einfache Aufgabe. In den meisten Fällen profitieren Sie wahrscheinlich davon, verschiedene Optionen zu prüfen, einschließlich der Beratung bei Cloud-GPU-Anbietern wie DataCrunch. Sprechen Sie noch heute mit unseren KI-Ingenieuren.